Veille : la GenAI donne près d'une réponse erronée sur deux

Selon une étude internationale menée par la BBC et l'UER auprès de 22 radiodiffuseurs publics internationaux, les moteurs de GenAI sont très loin d'être fiables. Avec près d'une réponse erronée ou imprécise sur deux, difficile d'en faire un outil de veille.

PublicitéUne nouvelle étude internationale, coordonnée par l'Union européenne de radio-télévision (UER, présidée par la présidente de France Télévisions, Delphine Ernotte Cunci) et dirigée par la BBC, montre que les assistants de GenIA déforment près de la moitié du temps le contenu des informations qu'ils partagent. 45% des réponses analysées contenaient en effet au moins une erreur considérée comme grave, 31% des citations de sources inadéquates ou trompeuses, et 20% des erreurs factuelles majeures, telles que des détails inventés ou des informations obsolètes.

Ces outils de GenAI sont imprécis dans leurs réponses, allant jusqu'à en inventer, modifier, voire créer des citations de toute pièce. Quant à la présence de sources, pourtant censées rassurer, elle doit elle aussi être prise avec des pincettes. Les réponses de Gemini de Google par exemple, qui a enregistré les plus mauvais résultats de l'étude, présentent des problèmes dans 76% des cas, principalement liés à un manque d'attribution de sources précises (absence de lien direct, voire citation très vague d'une source sur le modèle : « d'après des informations de la ZDF »).

Des progrès, mais peut beaucoup mieux faire

L'étude a porté sur 22 radiodiffuseurs publics répartis dans 18 pays et publiant en 14 langues (dont Radio France). Des journalistes professionnels ont analysé plus de 3 000 réponses fournies par ChatGPT d'OpenAI, Copilot de Microsoft, Gemini de Google et Perplexity AI de Perplexity. L'analyse « démontre de manière concluante que ces lacunes ne sont pas des incidents isolés, insiste Jean Philip De Tender, directeur des médias et directeur général adjoint de l'UER, dans un communiqué. Elles sont systématiques, transnationales et multilingues, et nous pensons que cela compromet la confiance du public. Or, lorsque [celui-ci ne sait plus] à quoi se fier, il finit par ne plus rien croire du tout, ce qui peut décourager la participation démocratique. »

Cette étude est la deuxième menée par la BBC et UER sur les mêmes assistants de GenAI à six mois d'intervalle. Et même si, contrairement à la première, la deuxième édition porte sur plusieurs pays, plusieurs langues et plusieurs organisations, et si des différences méthodologiques et statistiques existent entre les deux, la BBC estime que la comparaison peut au moins « donner une idée de la direction générale prise par les assistants » de GenAI. Le rapport affirme ainsi que « dans l'ensemble, il y a des signes d'amélioration de la qualité des réponses [...], - la part des réponses présentant des problèmes importants de quelque nature que ce soit est passée de 51% lors du premier tour à 37% lors du tour actuel ».

15% des moins de 25 ans s'informent via la GenAI

PublicitéLa 2e étude n'a, par exemple, rencontré que 25% de manque de précision contre 35% la première fois. Et c'est le mauvais élève, Gemini, qui s'améliore le plus, passant de 46% d'imprécisions à 25 %. Copilot s'est lui aussi amélioré, tandis que ChatGPT et Perplexity n'ont pas bougé. « Ce qui signifie, note cependant le rapport, que tous les assistants sont maintenant dans la fourchette de 20 à 29% pour des problèmes importants de précision ». Un taux qui demeure inacceptable.

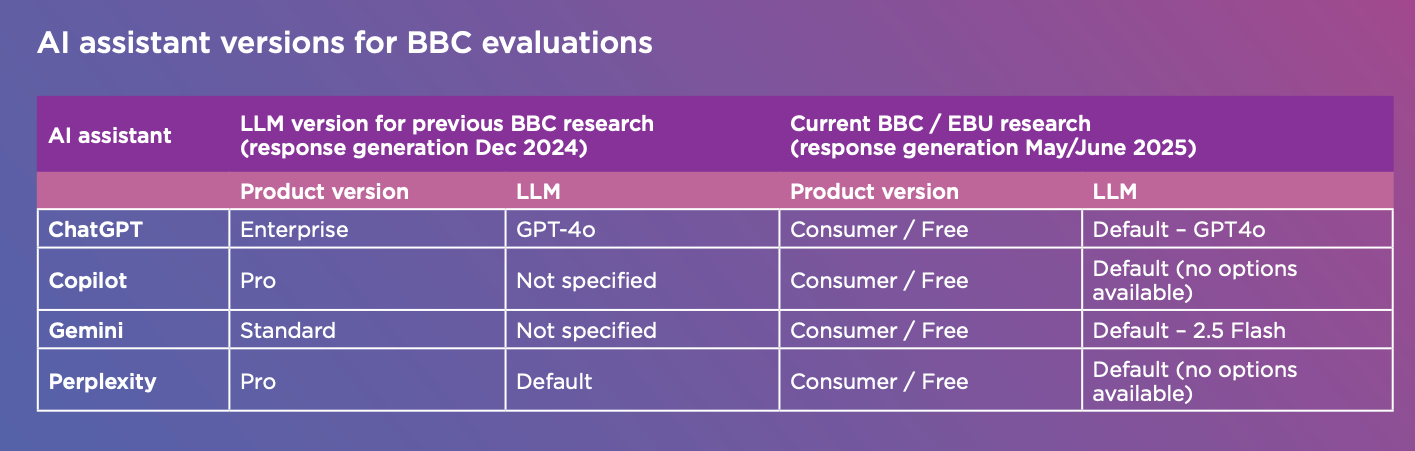

Les 4 GenAI mises à l'épreuve dans l'étude UER/BBC.

Les conclusions du rapport restent en effet très inquiétantes dans le cadre d'un usage intensif. D'autant que, comme le précise l'UER, « les assistants IA remplacent déjà les moteurs de recherche pour de nombreux utilisateurs. Selon le Digital News Report 2025 de l'Institut Reuters, 15% des moins de 25 ans utilisent des assistants d'IA pour s'informer, et c'est aussi le cas pour 7% de l'ensemble des consommateurs d'informations en ligne. Difficile de savoir si les DSI s'équipent, voire équipent leur entreprise, de GenAI pour de la veille informationnelle, par exemple, mais il est donc probablement urgent d'attendre avant de basculer. Ou tout au moins faut-il former et acculturer les équipes à la différence entre des outils de veille, des moteurs de recherche et des moteurs de GenAI, rappeler les bases de la vérification de l'information, si possible, prévenir ou encadrer le shadow AI, voire se doter de la boîte à outils qu'UER et la BBC ont conçue en parallèle de leur analyse.

Une boîte à outils pour les éditeurs et les utilisateurs

Cette « boîte à outils pour l'intégrité de l'information dans les assistants IA » vise à aider les développeurs et les utilisateurs à améliorer la qualité des réponses et à renforcer l'éducation aux médias. Mais elle s'adresse aussi aux éditeurs de GenAI, afin qu'ils évaluent plus précisément leurs outils à l'aune de la précision et de la véracité des réponses fournies. L'UER et la BBC ont également appelé l'UE et les autorités nationales à appliquer les règles existantes en matière d'intégrité de l'information, de services numériques et de pluralisme des médias, et à mettre en place un contrôle indépendant et permanent des assistants IA.

Article rédigé par

Viktor Eriksson, Computerworld (édité et complété par E.Delsol)

Commentaire

INFORMATION

Vous devez être connecté à votre compte CIO pour poster un commentaire.

Cliquez ici pour vous connecter

Pas encore inscrit ? s'inscrire