TotalEnergies raffine ses résultats de recherche avec le RAG

Pour mieux capitaliser sur ses retours d'expérience suite aux incidents de production dans ses raffineries, le groupe français mise sur une approche combinant recherche et IA générative personnalisée grâce à une approche RAG.

PublicitéMieux exploiter les retours d'expérience des équipes à la suite des pannes et dysfonctionnements survenus sur les sites de production, à commencer par les raffineries. C'est sur la base de cette feuille de route que l'équipe Smart Search Engines de la direction OneTech de TotalEnergies, soit la branche regroupant les expertises techniques et scientifiques du groupe, s'est lancé dans la conception d'outils de recherche pour les experts techniques et les équipes de maintenance. « Le premier besoin est venu de l'équipe chargée de la disponibilité de la raffinerie d'Anvers, à la suite d'un événement survenu sur place en 2021 », indique Aude Giraudel, la cheffe du service Smart Search Engines. En l'occurrence une fissure sur un équipement qui a engendré un arrêt de production de 4 jours, soit environ un million d'euros de manque à gagner sur la plus grande plateforme européenne de raffinage et de pétrochimie du géant français. Or, un événement similaire s'était déjà produit quatre ans auparavant. « Le constat, c'est que nous n'exploitions pas suffisamment les enseignements issus des événements passés, alors que ceux-ci sont pourtant documentés », reprend la responsable.

Lors des incidents affectant la production, les équipes de TotalEnergies rédigent en effet des retours d'expérience (REX) ou des analyses des causes (root cause analysis). Si les premiers en particulier sont dûment stockés dans des outils de capitalisation et de partage de l'information (comme SharePoint ou des GED), la recherche sur cette base de connaissances reste alors peu évoluée. D'où l'idée du service Smart Search Engines de proposer un moteur de recherche venant interroger cette dernière. Un premier prototype sort dès 2022, reposant sur la technologie Sinequa, avant son industrialisation dans le courant de 2023. Proposant des filtres spécifiques - sur un site ou un équipement donné -, le portail passe en production début 2024 sur le site d'Anvers, le déploiement sur les autres unités de raffinage et pétrochimie étant en cours.

« L'intégration de l'IA générative vise à interroger en langage naturel la base de REX et à proposer une synthèse des réponses aux utilisateurs », explique Aude Giraudel, la cheffe du service Smart Search Engines. (Photo : D.R.)

L'IA générative, une suite naturelle

Ce portail, aujourd'hui en anglais et baptisé Milaa (pour My Intelligent Learning Application for Availability), doit également progressivement devenir multilingue. « La finalité, c'est de proposer Milaa en quatre langues - anglais, néerlandais, allemand et français -, indique Pierre Jallais, architecte de solutions de recherche au sein de l'équipe Smart Search Engines. Le mécanisme multilingue est en cours de déploiement. » Un ensemble de fonctionnalités qui a nécessité des customisations importantes, du fait du vocabulaire spécifique manié par les experts techniques du groupe pétrolier. « Nous disposions d'un certain nombre de dictionnaires du vocabulaire métiers et de ressources sémantiques, par exemple sur les acronymes, reprend l'architecte. Mais encore faut-il les intégrer à l'outil de recherche, ce qui est loin d'être immédiat. » L'équipe Smart Search Engines estime toutefois que les travaux de développement autour de Milaa devraient s'achever à l'été.

Publicité

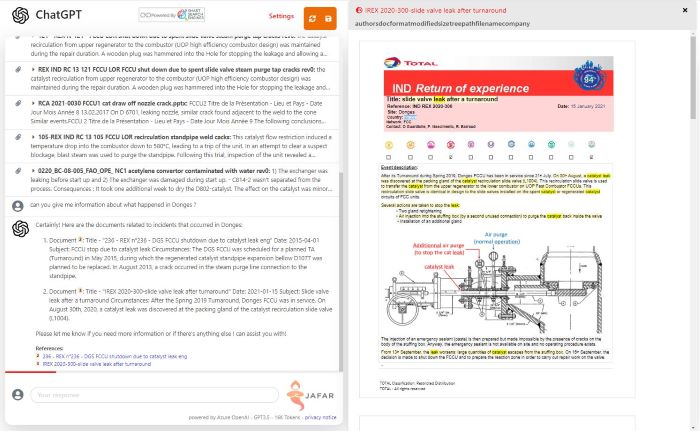

« Aujourd'hui, Jafar est avant tout employé par des experts techniques pour préparer les grands arrêts », précise Pierre Jallais, architecte de solutions de recherche au sein de l'équipe Smart Search Engines. (Photo : D.R.)

Entretemps, une évolution de la solution a vu le jour, intégrant l'IA générative. « C'est une suite logique, estime Aude Giraudel. Elle consiste à interroger en langage naturel la base de REX et à proposer une synthèse des réponses aux utilisateurs. » Autrement dit, à passer à un portail orienté sur la connaissance en livrant des condensés issus de plusieurs documents, tout en gardant la traçabilité vers les documents sources, dans le cas présent les quelque 5000 REX dont dispose TotalEnergies en consolidant les documents disponibles à Anvers et au siège parisien du groupe. Typique d'une utilisation du RAG (Retrieval Augmented Generation) que propose Sinequa en complément de ses outils de recherche, l'évolution du portail - rebaptisé Jafar (pour Generative AI for availability REX) - a donné lieu à un premier prototype réalisé en trois mois et basé sur GPT 4, le LLM d'OpenAI ici hébergé sur Azure. Un outil qui a été évalué auprès d'une trentaine d'experts, via une série de questions portant sur la pertinence des réponses fournies. « Nous venons d'obtenir la validation pour industrialiser l'approche et déployer plus largement cette version », indique la cheffe du service Smart Search Engines.

RAG, avant tout un effort sur la recherche

« Aujourd'hui, Jafar est avant tout employé par des experts techniques pour préparer les grands arrêts. Quand ils planifient ces interruptions programmées d'une raffinerie (afin d'en contrôler l'état et y effectuer l'ensemble des réparations, remplacements et aménagements requis, NDLR), ils apprécient les capacités de synthèse de l'outil », assure Pierre Jallais. Pour l'architecte, dans un deuxième temps, Jafar pourrait être ouvert aux opérateurs des raffineries, afin qu'ils puissent y préparer leurs interventions. « Mais des fonctionnalités multilingues seront alors indispensables, souligne l'architecte. Le défi consistera à donner la possibilité de poser une question en néerlandais pour aller chercher des documents en allemand renfermant des acronymes en anglais, par exemple ! » L'énergéticien s'oriente, pour ce faire, sur une combinaison entre une IA sur étagère et des ressources sémantiques internes. « La compagnie mène actuellement des réflexions sur l'application de modèles de langage élaborés en interne à partir des données de l'entreprise, principalement dans le secteur des géosciences. Les REX ne concernent que quelques milliers de documents, une quantité insuffisante pour envisager la formation d'un modèle », signale l'architecte.

Une capture d'écran de la solution Jafar. La combinaison de ChatGPT et de l'outil de recherche de Sinequa.

Pour Pierre Jallais, la complexité d'un développement RAG ne réside pas dans l'intégration de l'IA générative à proprement parler, mais plutôt dans la partie recherche. « Nourrir l'IA générative avec la bonne information représente 80% de l'effort, le solde étant consacré au paramétrage du LLM et au prompt engineering, assure-t-il. Et, l'effort de paramétrage de la recherche pour un outil comme Jafar est bien plus important que pour Milaa ; il faut être plus précis dans les réponses fournies en remontant les passages les plus intéressants. Régler la taille des paragraphes à transmettre au LLM demande en soi un travail important. » En parallèle de l'industrialisation de leurs outils, l'équipe d'Aude Giraudel et de Pierre Jallais travaille également sur des améliorations de Jafar, permettant de délivrer aux experts des squelettes de rapports à personnaliser sur la base de l'analyse de plusieurs REX. Mais aussi sur la réexploitation de l'architecture de cette solution pour d'autres besoins, en particulier pour un portail dédié aux géosciences.

En complément :

- Audi optimise sa documentation interne avec un chatbot à base d'IA

- Airbus s'essaie à l'IA générative en mode RAG

Article rédigé par

Reynald Fléchaux, Rédacteur en chef CIO

Suivez l'auteur sur Twitter

Commentaire

INFORMATION

Vous devez être connecté à votre compte CIO pour poster un commentaire.

Cliquez ici pour vous connecter

Pas encore inscrit ? s'inscrire