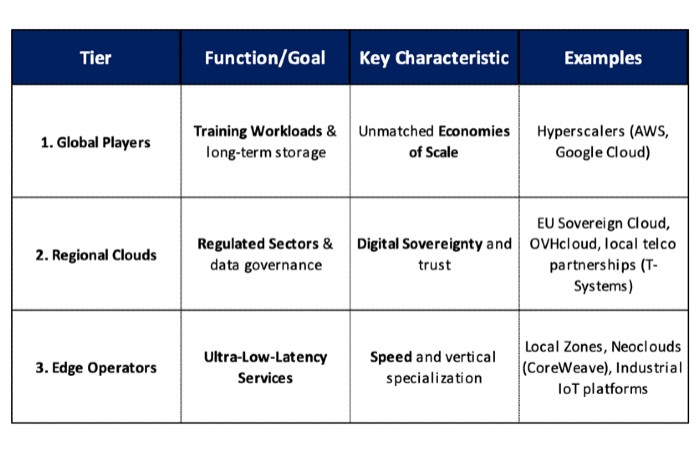

La grande migration du cloud vers un modèle à trois niveaux

Hyperscaler, cloud souverain local et edge computing. Ces trois composantes sont à la fois celles qui guident le marché du cloud et la transformation des modèles en entreprise. Une évolution impulsée par l'IA, les régulations data locales et les besoins de latence réduite, selon le rapport de la banque d'investissement Klecha & Co.

PublicitéLe cloud n'est pas mort. Il change de forme en s'écartant de plus en plus de son modèle historique basé sur les seuls hyperscalers. C'est le constat de la banque d'investissement privée italienne Klecha & Co, spécialisée dans les secteurs de l'IT, dans son étude « the end of the cloud as we know it ». Elle y explore en détail ces évolutions et leurs conséquences sur les stratégies d'entreprise. Pour Klecha & Co, le temps du cloud - solution universelle de la transformation digitale, avec ses hyperscalers centralisés proposant la flexibilité indispensable à la variation des besoins - est révolu. Trois forces convergentes ont conduit à ce point d'inflexion : l'explosion de la puissance de calcul nécessaire à l'IA qui épuise les grands clouds, la prolifération et le renforcement de régulations locales de la data partout dans le monde et enfin, « l'économie de la latence ». Cette dernière répond, pour certaines applications, à la nécessité de rapprocher la capacité de calcul de la data et de son utilisateur.

Le cloud bascule ainsi vers un modèle distribué, régulé et 'AI intensive', selon le rapport de Klecha & Co. Les entreprises s'orienteront, selon l'analyse, de plus en plus vers des infrastructures cloud à trois niveaux orchestrées dynamiquement par de l'IA, toujours avec les hyperscalers au coeur, mais avec des couches intermédiaires souveraines et enfin, des microgrids en edge. Une évolution déjà visible dans les politiques d'achat des organisations, selon Klecha & Co. « Le cloud passe de son économie d'échelle d'origine à une économie du contrôle. C'est-à-dire que, pour de nombreuses entreprises, le risque de non-conformité, le coût des temps de réponse trop lents ou la valeur liée à la conservation de leurs données propres et sensibles déterminent désormais davantage le choix de l'infrastructure que la simple obtention du prix le plus bas possible par unité de calcul ».

Explosion des investissements et distorsion des tarifs

L'IA est donc, sans surprise, une des causes majeures de cette transformation. Selon IDC, cité dans le rapport, elle a consommé près de la moitié des cycles de calcul du cloud public (47%) en 2025. « Cette bascule entraîne une distorsion des modèles de tarification, contraint de plus en plus la capacité de calcul disponible et conduit les grands hyperscalers à des investissements records » dans les datacenters destinés à l'IA, gonflés de GPU et de TPU (plus de 310 Md$ - soit 263 Md€ - en 2025, selon Morgan Stanley Equity Research). Alphabet, la maison mère de Google, vient tout juste d'annoncer à elle seule un niveau d'investissement pour 2026 compris entre 175 et 185 Md$ (entre 150 et 155 Md€ environ), soit le double du montant de 2025. Des comportements que la banque d'investissement estime faire écho à ceux observés avec les premiers développements de réseaux ferroviaires au 19e siècle ou lors du boom des télécoms dans les années 1990 : une débauche d'investissements en infrastructure, sans que le modèle de revenu ne soit totalement défini...

PublicitéC'est aussi l'IA et son appétit sans fin de données, associés au contexte géopolitique, qui conduisent de nombreuses régions du monde à renforcer leurs régulations de protection de la donnée locale et plus globalement du cloud, de la data et de l'IA. Il s'agit de protéger les citoyens et de répondre aux besoins des administrations et des entreprises de préserver leurs données les plus sensibles. Outre le RGPD, le Cloud Act ou l'AI Act européens, le rapport cite le Stargate AI infrastructure program américain, l'UAE National AI cloud aux Émirats arabes unis ou le Govtech sovereign cloud framework de Singapour. Selon le State of cloud report 2025 de l'éditeur américain de gestion des dépenses et des risques IT Flexera, le cloud souverain devrait passer de 9% des capacités cloud en 2025 à 20% en 2030.

Remise en cause du modèle physique du cloud

Avec l'IA et la régulation locale, le besoin de latence réduite est le 3e et plus étonnant paramètre à l'origine de l'évolution du cloud vers un type d'infrastructure, lui aussi plutôt atypique, l'edge computing. Devenu plus accessible et efficace avec l'arrivée de la 5G privée et bientôt de la 6G, ce dernier se fait concurrent des hyperscalers dans certaines conditions. Il séduit les entreprises pour exécuter directement le traitement de la data au plus près de celle-ci. C'est le cas de l'inférence des modèles d'IA, mais aussi des IA temps réel pour la détection de fraude, par exemple, du contrôle autonome ou encore de la réalité augmentée. Des systèmes qui requièrent des temps de réponse inférieurs à la dizaine de millisecondes contre quelques centaines pour des applications classiques. Selon les projections du cabinet d'étude Markets & Markets, le marché de l'edge devrait passer de 36 Md$ (30 Md€) en 2024 à 445 Md$ (378 Md€) en 2030.

Toutes ces mutations du cloud sous la pression de l'IA remettent également en cause, de fond en comble, le modèle physique du cloud, né dans des infrastructures homogènes et des datacenters globaux avec des alignements sans fin de CPU et d'équipements de stockage standards. Or, désormais, d'un côté, l'entraînement des modèles d'IA nécessite des clusters de GPU avec un couplage fort, alors que de l'autre, l'inférence requiert des équipements à faible latence distribués (en edge, en particulier). Dans cette perspective, le « compute as a service » frôle l'obsolescence, voire devient un véritable goulet d'étranglement. 40% des investissements monstres des hyperscalers dans de nouveaux datacenters en 2025 ciblent d'ailleurs des configurations à forte densité en GPU.

Stratégies multicloud et émergence de néoclouds

Face à ces transformations, les entreprises se tournent de plus en plus vers des stratégies multicloud et le marché voit l'émergence de néoclouds plus transparents que les hyperscalers. 83% des grandes entreprises dans le monde auraient ainsi déjà fait le choix du multicloud, selon Flexera, afin d'alléger leur dépendance à un hyperscaler, même au prix d'une gestion plus complexe des SI. Par ailleurs, la mainmise de l'oligopole AWS, Azure, GCP, Meta avec 355 Md$ (300 Md€) de capex investis principalement dans l'IA, peu enclin à la transparence ni à une tarification juste, fait émerger un marché de néoclouds. Coreweaves ou Lambda labs, par exemple, proposent des offres aux configurations GPU optimisées (GPUaaS) et aux tarifs transparents. Cerise sur le gâteau, ces configurations nécessitent en moyenne une puissance de 50 à 200 MW contre 1 GW pour les géants du cloud. Ces néoclouds jouent qui plus est l'ouverture au-delà de la seule infrastructure matérielle, avec des stacks IA containerisées, des containers d'inférence Hugging Face ou des microservices d'inférence Kubernetes Nim, pour la portabilité des modèles.

Synergy Research estimait en octobre dernier que le marché des néoclouds atteindrait 23 Md$ fin 2025, avec une croissance qui le porterait à 180 Md$ dès 2030. Ces nouveaux acteurs attirent déjà l'intérêt des investisseurs, mais aussi des vendeurs de puces. Ces derniers les voient comme des alliés, sorte de laboratoires de test de haut niveau avant une validation par les hyperscalers. Ce qui signifie que, comme les hyperscalers, les néoclouds bénéficient systématiquement des modèles de GPU les plus récents. Nvidia les accueille par exemple au sein de son programme d'accès anticipé à ses derniers designs, le DGX Cloud Partner Program.

FinOps et stratégie, au-delà de la seule technologie

Ces évolutions du cloud ne concernent pas que les DSI, CTO et autres RSSI, car elles influent autant sur les choix de technologies et d'opérateurs de cloud, que sur la gouvernance et le FinOps. Le tout avec un regard fin sur l'équilibre entre risque et valeur apportée. Le passage d'une infrastructure centralisée chez les hyperscalers, à une architecture distribuée, en particulier sur du edge, exige par exemple une attention renforcée à la sécurité et à l'observabilité. « L'éclatement des workloads entre de multiples fournisseurs augmente de façon exponentielle la surface d'attaque et le besoin de monitoring de la data. Les équipes de sécurité doivent faire face à des logs fragmentés, à des systèmes d'identité incohérents et à des normes de chiffrement différentes. L'industrie répond avec des pipelines de télémétrie unifiés et des modèles zéro trust (ZTNA) s'étendant du cloud coeur jusqu'à l'équipement en edge », écrivent les analystes de Klecha & Co. Quant à l'observabilité, elle devient un avantage concurrentiel, avec des outils qui corrèlent les coûts, la performance et l'impact carbone pour chaque workload. « La quantification financière de la latence et de la consommation d'énergie donne aux entreprises la capacité de négocier en temps réel des objectifs par service cloud auprès de chacun des différents fournisseurs », affirme la banque.

Les DAF et les directions de la stratégie sont donc tout aussi concernés que la DSI. L'orchestration multicloud exige, en effet, à la fois une discipline des coûts et la définition de nouveaux indicateurs. Comme l'explique la banque d'investissement à l'origine de l'étude, « les architectures hybrides nécessitent une allocation du capital entre les actifs sur site, la colocation et les hyperscalers. De plus, les entreprises considèrent de plus en plus la connectivité et la latence comme des éléments de bilan, comme les coûts énergétiques ou logistiques le sont déjà. [...] Stratégiquement, le multicloud représente la phase finale de la décentralisation du cloud. Ce qui a commencé comme un mouvement pour externaliser l'informatique exige désormais une gouvernance interne accrue et une expertise spécialisée. »

Pour Klecha & Co, la prochaine révolution du cloud se fera bien sous le signe d'une économies du contrôle, « dans lesquelles la valeur provient du contrôle spécialisé et garanti sur les ressources », autrement dit la data, la latence, et sur l'allocation de GPU, ressources rares et fortement demandées.

Article rédigé par

Emmanuelle Delsol, Journaliste

Suivez l'auteur sur Linked In,

Commentaire

INFORMATION

Vous devez être connecté à votre compte CIO pour poster un commentaire.

Cliquez ici pour vous connecter

Pas encore inscrit ? s'inscrire