Le coût des GPU pour l'IA pèse sur les budgets IT 2026

À mesure que l'IA devient une dépense récurrente, les décideurs informatiques considèrent celle-ci avec de plus en plus d'attention. Les coûts liés à l'utilisation des GPU dans les datacenters pourraient augmenter autant que les coûts globaux liés à l'IA.

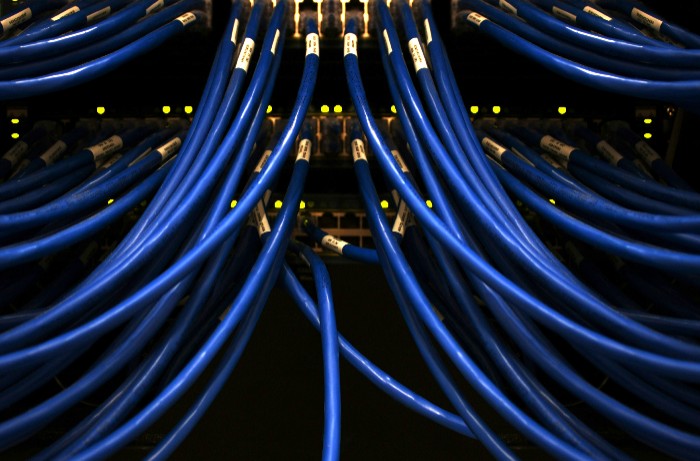

PublicitéSi l'IA devient presque une commodité comme une autre, elle engendre des dépenses loin d'être négligeables. Face à ce constat, les DSI, qui bouclent leurs budgets pour 2026, doivent désormais tenir compte du coût des ressources sous-jacentes qu'elle mobilise. Au premier rang desquelles les GPU des datacenters. Au cours des trois années qui ont suivi l'arrivée de ChatGPT, la course à la création d'outils de GenAI toujours plus nombreux et performants s'est poursuivie à un rythme effréné. Cette croissance a toutefois eu un prix : des budgets IA en progression constante, une disponibilité réduite des GPU et une capacité énergétique limitée pour faire fonctionner les datacenters. Des efforts sont actuellement déployés pour réduire le coût d'utilisation des GPU et des services de GenAI associés : centres de données plus petits, logiciels et outils de facturation dédiés, équipements dédiés pour supporter la charge...

La capacité à budgéter efficacement l'IA dépend de plusieurs paramètres, en particulier du prix des GPU, du temps d'exploitation et du prix des instances. Ces dernières apparaissent extrêmement coûteuses, à plus de 30 dollars de l'heure pour les configurations haut de gamme, selon Corey Quinn, économiste en chef chez Duckbill, qui fournit des outils d'analyse des coûts du cloud. « Pour les charges de travail IA importantes, les coûts des GPU deviennent souvent le poste budgétaire principal, ce qui explique pourquoi les entreprises se disputent les capacités réservées et les instances spot », précise-t-il. Il ajoute que la facturation de l'IA via les services cloud « est un véritable casse-tête ». Or, en la matière, les responsables IT ne peuvent pas s'engager sur des ressources informatiques fixes en raison du caractère imprévisible des charges de travail IA. Et pour compliquer un peu plus les choses, les hyperscalers brouillent davantage les cartes avec des services GPU managés, des crédits IA et des remises pour les engagements sur les usages. À cela s'ajoutent « les coûts cachés que tout le monde oublie : le transfert de données, le stockage des données d'entraînement et le temps d'ingénierie nécessaire pour que tout cela fonctionne », indique Corey Quinn.

Optimisations des coûts GPU dans le viseur

Dans le même temps, les NCP (néocloud) se procurent davantage de GPU et les mettent à la disposition des utilisateurs. Parmi ces entreprises figurent CoreWeave, Lambda Labs et Together AI. « Elles gagnent des parts de marché significatives en se concentrant exclusivement sur les charges de travail GPU et en proposant souvent des prix inférieurs de 30 à 50 % à ceux des hyperscalers », explique Corey Quinn. Ces entreprises se concentrent davantage sur les GPU à prix réduit dans une zone géographique plus restreinte, ce qui convient à certaines entreprises.

PublicitéPour Laurent Gil, cofondateur de Cast AI, spécialisé dans le FinOps, les responsables IT n'ont néanmoins pas besoin des GPU les plus récents et les plus performants de Nvidia ou d'AMD pour leurs applications d'IA. Les anciennes générations sont tout aussi performantes pour certaines tâches, et les responsables informatiques doivent savoir où les trouver pour faire des économies. « Le prix spot AWS pour les A100 et H100 de Nvidia a baissé de 80% entre l'année dernière et cette année, mais pas partout », précise-t-il. Cast AI propose des logiciels et des agents IA nécessaires pour transférer les workloads vers des GPU moins chers chez différents fournisseurs de cloud et dans différentes régions. « Nos agents font ce qu'un humain fait une fois par mois, sauf qu'ils le font à chaque seconde », poursuit Laurent Gil. Ils optimisent également les processeurs, qui consomment beaucoup moins d'énergie que les GPU.

Les réseaux électriques surchargés par la demande IA

Certaines entreprises cherchent également à rendre les prix et la disponibilité des GPU plus transparents. Une start-up américaine, Internet Backyard, propose ainsi aux fournisseurs de datacenters de fournir des devis, des factures, des paiements et des rapprochements en temps réel pour la capacité GPU. Le logiciel en marque blanche est intégré à leurs systèmes informatiques. « Un portail des instances dans les datacenters permet de voir en temps réel les prix des GPU et l'énergie correspondant à la consommation réelle », détaille Mai Trinh, CEO d'Internet Backyard. La jeune pousse ne collabore pas encore avec les hyperscalers. Pour l'instant, elle se concentre davantage sur les datacenters émergents qui ont besoin de normaliser la facturation, les devis et le traitement des paiements. « Lorsque nous discutons avec les personnes qui construisent un centre de données, elles nous disent que tout se passe sur Excel et qu'il n'y a pas de tarification en temps réel », explique Mai Trinh. L'IA étant liée à la performance, l'entreprise explore un modèle de tarification basé sur cet indicateur plutôt que sur les GPU. « Il est extrêmement important pour nous de baser la tarification sur les performances, car c'est ce pour quoi vous payez réellement, explique Mai Trinh. Vous ne payez pas pour l'actif déprécié de quelqu'un d'autre. » Parmi les investisseurs de la start-up figure Jay Adelson, cofondateur d'Equinix, l'une des plus grandes sociétés de datacenters au monde.

L'énergie est également un facteur important dans la fixation des prix des GPU. La demande en GPU pour le calcul IA submerge les réseaux électriques, qui ont des plafonds de puissance. Ce qui fait grimper les prix. Selon une étude McKinsey de 2024, les datacenters américains pourraient représenter 12% de la consommation totale d'énergie dans le pays d'ici 2030. Parallèlement, les prix de l'électricité montent en flèche en raison de la frénésie de construction de nouveaux datacenters. Récemment, plusieurs groupes ont envoyé une lettre au Congrès américain pour demander un moratoire sur la construction de centres de données. Les besoins énergétiques tels que ceux requis par les grands fournisseurs d'IA pour leurs futurs datacenters ne sont pas viables, rappelle Peng Zou, CEO de PowerLattice, société qui développe des technologies pour que les puces modernes soient plus efficaces sur le plan énergétique. « La fiabilité et la disponibilité des serveurs IA sont essentielles, et ce sont des aspects auxquels les directeurs informatiques accordent une grande importance », souligne Peng Zou.

Article rédigé par

Agam Shah, Computerworld (adapté par Dominique Filippone)

Commentaire

INFORMATION

Vous devez être connecté à votre compte CIO pour poster un commentaire.

Cliquez ici pour vous connecter

Pas encore inscrit ? s'inscrire