6 risques data à l'ère de l'IA qui rendent les DSI paranoïaques

Des données mal classées à l'utilisation de l'IA sans assurance d'une qualité de data suffisante, les DSI qui cherchent à tirer le meilleur parti de la donnée interne et externe pour les prises de décision peuvent nourrir un certain niveau de paranoïa.

PublicitéLes directions générales poussent les DSI à fournir des analyses prédictives ou à transformer le fonctionnement des équipes avec des agents d'IA. Pour autant, les investissements dans la gouvernance, les opérations et la sécurité des données sont trop souvent relégués au second plan face aux projets métier, ce qui en pratique compromet le succès de l'IA.

Pour combler ces lacunes et s'assurer que la supply chain data est l'objet de suffisamment d'attention au plus haut niveau, les DSI se sont d'abord adjoint les compétences des CDO, leur confiant la gestion de la dette de données, l'automatisation des pipelines de données et le passage à un modèle de gouvernance proactif, centré sur les indicateurs de santé des data, sur leur qualité et sur l'interopérabilité des modèles. Mais les DSI ne doivent pas non plus trop déléguer ces responsabilités. Ceux qui cherchent à tirer une valeur business des investissements dans l'IA en particulier, doivent accorder davantage d'attention aux risques liés aux données susceptibles de compromettre cet objectif.

Un certain niveau de paranoïa des DSI à l'égard des risques liés à l'exploitation de la data à l'ère de l'IA, en particulier en ce qui concerne la propriété intellectuelle et les capacités émergentes de l'IA, est tout à fait sain. Voici six risques de ce type qu'ils devraient examiner de près et face auxquels ils devraient doter leurs équipes de stratégies de remédiation. Idéalement, pour transformer ces dangers en opportunités stratégiques.

1. Des données mal classées et des data owners désengagés

Demandez à n'importe quel responsable de la gouvernance des données quelles sont ses principales difficultés pour améliorer la qualité des données et se conformer aux réglementations. En tête de liste, figurent l'identification et le niveau d'implication des data owners dans la définition et le respect des politiques data. Si ceux-ci ne sont que peu impliqués, les données utilisées dans l'IA peuvent être mal classées, ce qui pourrait enfreindre les règles de confidentialité et d'autres réglementations. De plus, à l'ère de l'IA, les données non classées posent une autre question : les data scientists peuvent-ils utiliser ces data dans des modèles sans respecter la conformité requise ou la gouvernance des données doit-elle les en empêcher ?

Les DSI directement impliqués dans la gouvernance data arrivent souvent à convaincre plus efficacement les chefs de département de désigner des data owners. Les besoins en citizen data scientists et l'envie d'obtenir des avantages métiers avec l'IA sont trop importants pour que les dirigeants refusent d'en assumer la responsabilité. De plus, une fois que ces data owners sont impliqués, il est plus facile de les faire participer à la gouvernance de l'IA et de les associer au pilotage des agents.

Publicité2. L'exposition de la propriété intellectuelle à l'IA

De nombreux DSI sont par ailleurs préoccupés par le shadow AI, lorsque les employés utilisent des LLM publics et expérimentent d'autres outils de GenAI que ceux approuvés par l'entreprise. Le partage de données mal classées et l'exposition de propriété intellectuelle avec ces solutions constituent des risques importants. Les employés utilisent en effet parfois des données, du code, des éléments de la charte de marque, des contrats ou des sections de documents sensibles dans leurs prompts. La propriété intellectuelle peut aussi être mise en danger lorsque les data scientists s'en servent pour entraîner des modèles d'IA, pour du RAG ou de la création d'agents, sans les autorisations requises.

« Les données sont l'un des actifs les plus précieux qu'une entreprise possède, et elles doivent être protégées en tant que tel, insiste Joe Locandro, DSI monde du spécialiste de la maintenance logiciel Rimini Street. Les DSI doivent être vigilants face à ce type de manipulation de données par les employés, face à l'utilisation abusive des outils d'IA ou face à une mauvaise hygiène cyber. Il est essentiel de donner la priorité à la formation du personnel à une bonne utilisation des data dans l'IA, au masquage des données sensibles dans les systèmes principaux et à des audits réguliers de la sécurité des données ». Srujan Akula, PDG de l'éditeur de plateformes data The Modern Data Company, conseille lui aux DSI de créer des data products à partir de datasets dignes de confiance et de leur associer des data product owners bien identifiés et une gouvernance claire.

Pour transformer ce risque en avantage, les DSI peuvent aussi déployer des programmes de formation à la data et, sur le modèle de l'open innovation, encourager tous les employés à soumettre des idées. Une combinaison qui encourage l'apprentissage et la résolution de problèmes, mais donne aussi à l'organisation une visibilité sur un plus grand nombre de projets émanant des employés.

3. Des sources de données tierces mal maîtrisées

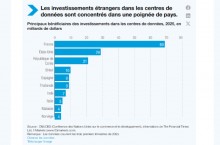

Les seules entreprises américaines devraient dépenser plus de 26 Md$ (environ 22,2 Md€) en achat de données marketing en 2025. Celles-ci sont généralement utilisées pour la segmentation de la clientèle ou la personnalisation des campagnes. S'il est déjà difficile de s'assurer que les pratiques internes en matière de données respectent les exigences réglementaires et la gouvernance interne, le suivi de la conformité des data issues de sources tierces est un défi d'une tout autre ampleur. « L'un des risques les plus négligés réside dans l'utilisation de pipelines de données tiers ou de services d'enrichissement de data sans en vérifier la source, confirme Luis Lacambra, responsable produit chez le prestataire data Soax. Si elles sont récupérées ou agrégées à partir de sources publiques avec des méthodes peu fiables ou non conformes, votre organisation pourrait s'exposer à un audit réglementaire ou se retrouver dans des angles morts opérationnels ». L'examen de la conformité des données tierces devrait être un élément non négociable de la gouvernance des données.

Les entreprises achètent et intègrent par ailleurs de nombreuses sources qui ne sont pas utilisées, qui fournissent des informations en doublon avec d'autres sources ou qui n'apportent qu'une valeur marginale. Les DSI à la recherche de réduction de coûts devraient procéder à un audit coûts-avantages des sources de données tierces, examiner leur utilisation et quantifier les risques, afin d'éliminer les sources à faible valeur ajoutée et à risque élevé.

4. Une mauvaise observabilité des pipelines de data

La plupart des entreprises investissent dans des plateformes d'analyse de données et des outils de traitement de documents pour les utilisateurs, avant de se doter de solutions d'intégration de data et de pipelines robustes. Alors que les différents services dans l'organisation dépendent de plus en plus des données en temps réel pour prendre des décisions, la fiabilité et la performance des pipelines de données peuvent devenir un cauchemar opérationnel. Et ce, en particulier lorsque les responsables data passent leur temps à résoudre des problèmes ou si des données qui arrivent trop tard entraînent de mauvaises décisions.

Les DSI doivent être conscients des risques liés aux données qui menacent l'intégrité de l'organisation, ainsi que des enjeux relatifs à la sécurité et à l'efficacité de la prise de décision. Une visibilité limitée sur les pipelines de données et les modèles d'utilisation avec une observabilité insuffisante peut ainsi dissimuler des problèmes de latence, de dérive des données, de défaillances des pipelines, ou compromettre l'emplacement du stockage des données sensibles.

L'observabilité DataOps comprend la surveillance des pipelines de données, l'automatisation des réponses et le suivi des performances. Les mesures de DataOps, elles, comprennent la fiabilité du pipeline, les taux d'automatisation, les taux d'exception et le débit de traitement. Et la réduction d'incidents liés au DataOps peut représenter une économie pour les DSI qui intègrent de nombreuses sources de données et utilisent des data fabrics. Mais, plus important encore, l'intégration de données non fiables érode la confiance, ce qui peut ralentir le déploiement d'IA et des pratiques centrées sur les données au sein de l'entreprise.

5. Les lacunes dans la qualité des données

Les DSI ont longtemps lutté pour améliorer la qualité des données en désignant des data stewarts, en automatisant les procédures de data cleansing et en mesurant la santé des données. Cependant, la plupart de ces tâches portent sur des sources de données structurées dans les ERP, les CRM et les datawarehouses. Or, l'IA en a élargi le champ aux données non structurées et aux référentiels de documents utilisés pour alimenter les modèles et fournir des réponses pertinentes en fonction du contexte, avec le RAG ou les agents d'IA.

Le RAG permet aux entreprises d'accéder à des connaissances organisationnelles, mais ce n'est pas sans risque d'atteinte à la confidentialité des données, d'hallucinations ou de complexification de l'intégration. La mise en oeuvre nécessite d'investir dans la qualité des données, d'établir des cadres de gouvernance et de créer des systèmes d'évaluation avant de passer à l'échelle.

Pour combler les lacunes en matière de qualité des données, les DSI devraient centraliser les données brutes dans des datalakes, proposer le data cleansing comme un service partagé et donner accès aux données via des data fabrics et des plateformes de données clients.

6. La surestimation des réponses de l'IA sans assurance sur la qualité des data

La gouvernance de l'IA peut être définie à partir de 7 questions, dont celles sur la valeur métiers, la sélection des outils, la conformité et la gouvernance des données. Mais un des défis majeurs réside dans la façon dont les employés valident ou au contraire remettent en question la réponse d'un LLM ou les recommandations d'un agent d'IA. Cette question est d'autant plus importante pour les DSI qui cherchent à développer des agents, car les pratiques d'assurance qualité pour tester les LLM sont encore émergentes et reposent souvent sur des tests manuels.

Les DSI doivent pourtant surveiller en permanence l'exactitude et la fiabilité des résultats générés par l'IA. Les LLM n'étant pas déterministes, la définition même de la qualité de ces résultats est complexe et les frontières entre l'ingénierie, l'assurance qualité et le produit s'estompent progressivement. Cette évolution exige une collaboration plus étroite entre les équipes pour s'assurer que les utilisations de l'IA sont dignes de confiance, alignées sur les besoins des utilisateurs et capables de générer de véritables résultats business.

Il est plus facile pour un DSI de justifier le recrutement de développeurs ou l'augmentation des systèmes de résilience et de sécurité que des investissements dans la qualité data ou les tests sur l'IA. Mais cela pourrait changer à mesure que de plus en plus de développeurs utilisent des générateurs de code à base d'IA et que les opérations informatiques sont de plus en plus automatisées.

Article rédigé par

Isaac Sacolick, CIO US (adapté par E.Delsol)

Commentaire

INFORMATION

Vous devez être connecté à votre compte CIO pour poster un commentaire.

Cliquez ici pour vous connecter

Pas encore inscrit ? s'inscrire