Groupama adopte un datalake industrialisé

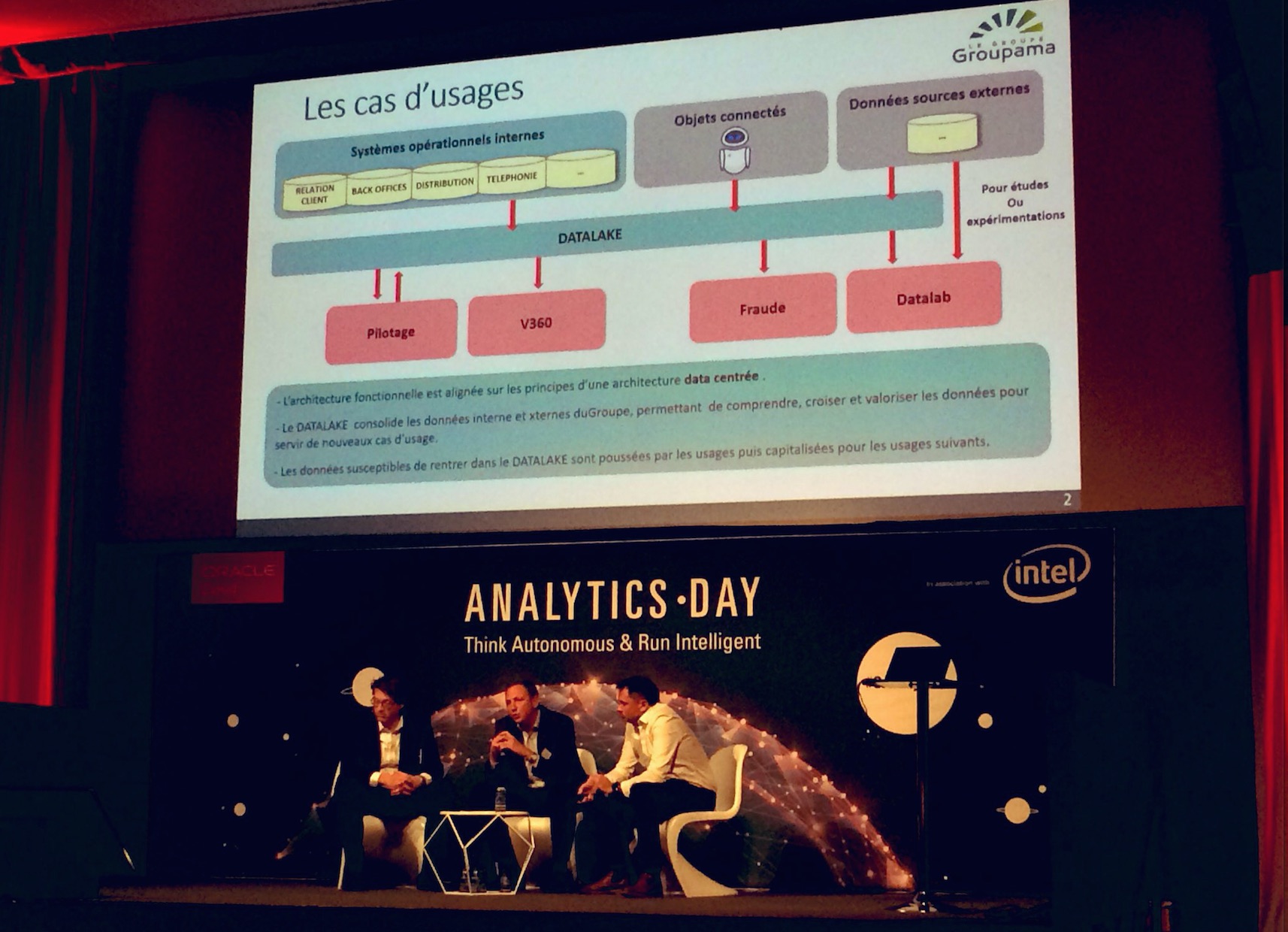

En s'appuyant sur un datalake qui consolide ses données internes et externes, Groupama a bâti une plateforme pour construire des cas d'usage d'analyse des big data pour ses métiers. Le projet a déjà permis d'installer du pilotage décisionnel, une vision 360 du client et de la détection de fraude sur l'IARD. Par ailleurs, un datalab hébergé dans le cloud permet à une équipe de data scientists d'explorer les cas d'usage futurs.

PublicitéComme toutes les compagnies d'assurance, Groupama est particulièrement centré sur les données, mais un vrai virage s'est produit en 2015 avec la décision de mettre en oeuvre une plateforme big data à l'échelle du groupe. Celle-ci devait à la fois permettre d'étendre les projets de BI, et d'accompagner la stratégie du groupe français en termes de données. C'est ce qu'on exposé Antoine Hacquard, responsable division architecture et urbanisme de l'entité Support et Services de Groupama, et Pascal Desseaux, responsable des infrastructures big data de l'assureur français. Tous deux sont intervenus cette semaine sur l'événement Oracle Analytics Day qui s'est tenu le 16 avril à Paris, dans le cadre du Grand Palais.

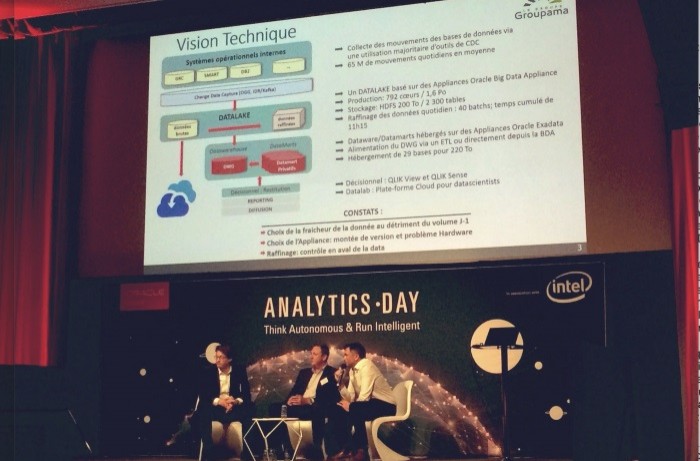

La plateforme centralisée bâtie par Groupama s'articule autour d'un data lake sur base Hadoop qui a permis de décloisonner l'ensemble des données. A l'échelle nationale, Groupama comprend en effet 10 caisses régionales auxquelles s'ajoute la marque GAN, avec des systèmes opérationnels cloisonnés. Le data lake transversal sert quatre cas d'usage qui sont ainsi construits sur une vision globale des données pour couvrir la satisfaction client, la fraude et l'attrition. Un premier cas d'usage porte d'abord sur le pilotage. En aval du data lake, un datawarehouse groupe fournit des indicateurs réalisés de manière communautaire.

Ci-dessus, de droite à gauche, Antoine Hacquard, responsable division architecture et urbanisme de l'entité Support et Services de Groupama, Pascal Desseaux, responsable des infrastructures big data, et Eric Delfosse, directeur Oracle Analytics chez Oracle France. (agrandir l'image)

200 téraoctets de données raffinées

Le 2ème cas d'usage concerne la vision 360 des clients. Il s'agit d'un système opérationnel avec des applications qui vont se sourcer sur le data lake en permanence. Le 3ème cas d'usage permet de détecter la fraude IARD, sur l'assurance dommage - plusieurs millions d'euros - en croisant des modèles et des données à l'échelle du groupe pour pouvoir identifier des réseaux, ont expliqué Antoine Hacquard et Pascal Desseaux. Enfin, la 4ème utilisation de la plateforme big data est un datalab pour les data scientists destiné à explorer les usages de demain. Il s'agit d'un environnement isolé de type bac à sable, hébergé dans le cloud, qui n'est pas rafraîchi quotidiennement comme l'est le data lake, mais tous les mois.

Pour mettre en oeuvre cette plateforme, Groupama a choisi d'installer les appliances Big Data d'Oracle. Le système installé est doté de 792 coeurs avec des capacités de stockage de 1,6 Po. L'investissement de départ a sans doute été important par rapport à d'autres choix possibles, mais il permet d'anticiper largement les besoins à venir. La collecte des mouvements de base de données se fait via une utilisation majoritaire de l'outil de CDC (change data capture). Il y a en moyenne 65 millions de mouvements techniques au quotidien (à titre d'exemple, une centaine pour un client dans le CRM). Le volume de données raffinées s'élève à 200 To sur stockage HDFS avec 2 300 tables. Le raffinage des données se fait chaque jour (40 batchs). La partie datawarehouse/datamarts est de son côté hébergée sur des appliances Exadata. L'alimentation de l'entrepôt de données se fait à partir d'un ETL ou directement depuis la base de données autonome d'Oracle (29 bases sont hebergées pour 220 To). Enfin, les applications décisionnelles s'appuient sur les outils de requête et visualisation Qlik.

Publicité Un fort investissement en recrutement et formation

Quatre ans après le lancement du projet, la plateforme en production est industrialisée. Elle permet non seulement de servir les cas d'usage évoqués mais aussi de projeter une vraie stratégie data pour Groupama. Les appliances installées sont gérées par Oracle de façon quasiment transparente pour l'entreprise avec pratiquement deux montées de version par an. Le fait d'avoir mis en place cette organisation pour administrer la plateforme permet d'envisager les cas d'usage futurs. « Nous avons fait le choix d'internaliser les compétences avec un effort important en termes de recrutement et de formation et des choix technologiques qui s'avèrent pertinents », a exposé Pascal Desseaux, responsable des infrastructures big data. « Il reste un travail très important sur toute la partie industrialisation, un travail permanent en fait, et sur les les montées de version régulières sur les composants techniques de la plateforme », précise-t-il en soulignant un point majeur : « la plateforme coûte si on ne s'en sert pas ».

Article rédigé par

Maryse Gros, Journaliste, chef de rubrique LMI

Partager cet article

Articles à la une

Khaled Bagban, DSI de Metro : « Le plus grand défi de l'IA est l'adoption des outils »

Baromètre Cesin 2025 : des attaques plus virulentes, mais une plus grande résistance

Commentaire

INFORMATION

Vous devez être connecté à votre compte CIO pour poster un commentaire.

Cliquez ici pour vous connecter

Pas encore inscrit ? s'inscrire